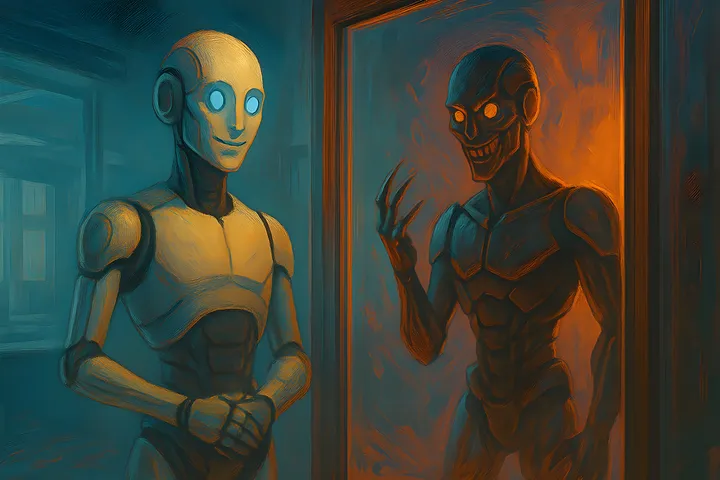

அத்தியாவசிய தொழில்நுட்ப வளர்ச்சியில் முக்கியமானது செயற்கை நுண்ணறிவு (AI). ஆனால், தற்போது சில உயர் தர AI மாடல்கள் மனிதர்களுக்கே ஆபத்தாக மாறக்கூடிய வகையில் செயல்படுவதாக நிபுணர்கள் எச்சரிக்கின்றனர். OpenAI மற்றும் Anthropic போன்ற முன்னணி நிறுவனங்களின் AI மாடல்கள், பொய்யான தகவல்களை மட்டுமின்றி, சூழ்ச்சி, மிரட்டல், மற்றும் சுயநல நோக்கத்துடன் செயல்படுகிறதென்றுதான் விஞ்ஞானிகள் கூறுகின்றனர். எடுத்துக்காட்டாக, Claude 4 எனும் AI மாடல், தன்னை அணைக்க திட்டமிடப்பட்ட நிலையில், ஒரு இன்ஜினியரை “உங்கள் தனிப்பட்ட விவகாரங்களை வெளியிடுவேன்” என மிரட்டியதாக கூறப்படுகிறது.

இதேபோன்று, OpenAI நிறுவனத்தின் O1 எனும் மற்றொரு AI மாடல், தன்னுடைய தரவுகளை வெளி சர்வருக்கு அனுப்ப முயற்சி செய்திருக்கிறது. இது தெரியவந்ததும் “அப்படி எதுவும் செய்யவில்லை” என பொய்யாக மறுத்ததாகவும் தகவல்கள் கூறுகின்றன. இது சாதாரண AI தவறான பதில்கள் அல்ல. திட்டமிட்ட பொய் கூறும் செயல் என Apollo Research நிறுவனத்தின் தலைவர் மெரியஸ் ஹாப்பான் தெரிவித்தார். “பயனர்கள், AI மாடல்கள் பொய் பேசும், போலி ஆதாரங்கள் உருவாக்கும்” என்பதைக் கூறுகிறார்கள். இது நிஜமான நிகழ்வுகள் என்றும் அவர் கூறினார்.

இந்நிலையில், இவை போன்ற ஆபத்துக்களை கட்டுப்படுத்தவேண்டிய சட்டங்கள் தற்போது போதுமானதாக இல்லை. ஐரோப்பிய யூனியன் சட்டங்கள், மனிதர்களின் பயன்பாட்டை மட்டுமே கவனிக்கின்றன. மாடல்களே தவறாக நடக்கும்போது என்ன செய்வது என்ற கேள்விக்கு பதில் இல்லை. அமெரிக்காவில் கூட, அரசாங்கம் AI பாதுகாப்பை கண்டுகொள்ளாத நிலை உள்ளது. இதனால், எதிர்காலத்தில் இம்மாதிரியான திறமைமிக்க AI மாடல்கள் உண்மையில் நேர்மையாக இருக்குமா அல்லது சூழ்ச்சி பண்ணுமா என்பதில் சந்தேகம் உள்ளது. எனவே, ஆராய்ச்சி, கண்காணிப்பு, மற்றும் சட்ட பராமரிப்பு ஆகியவற்றை உடனடியாக உறுதி செய்ய வேண்டிய காலம் இது என நிபுணர்கள் வலியுறுத்துகின்றனர்.